Mimo że od wielu miesięcy temat filtrów jest na topie, cały czas pojawiają się nowe osoby, dla których jest to ich „pierwszy raz” i które pytają – skąd mam wiedzieć, które linki zostały uznane za nienaturalne? Niestety Google nam tego nie ułatwia, bo mimo kilku już zapowiedzi, nadal nie otrzymujemy w powiadomieniu w GWT ich przykładów.

Mimo że od wielu miesięcy temat filtrów jest na topie, cały czas pojawiają się nowe osoby, dla których jest to ich „pierwszy raz” i które pytają – skąd mam wiedzieć, które linki zostały uznane za nienaturalne? Niestety Google nam tego nie ułatwia, bo mimo kilku już zapowiedzi, nadal nie otrzymujemy w powiadomieniu w GWT ich przykładów.

Osoby, które kompletnie się w tym gubią, mogą skorzystać z narzędzi takich jak Link Detox (tutaj można skorzystać z darmowego triala), które dokonuje automatycznej analizy backlinków. Niestety oparcie się o sam automat może niewiele pomóc, ponieważ analiza powinna być dość szczegółowa, a ufając w 100% danym z jakiegokolwiek narzędzia można pozbyć się także wielu wartościowych linków, które zostały błędnie zakwalifikowane do toksycznych. Zawsze to jednak jakiś początek.

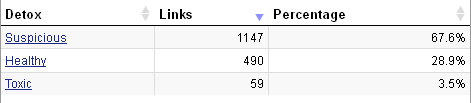

Jak zatem rozpoznać toksyczne linki? Zacznę od przykładów z Link Detoxa, a później przejdę do elementów wspólnych dla zafiltrowanych stron, które miałam okazję analizować. Przede wszystkim do narzędzia należy wgrać plik z linkami pobranymi z GWT, aby analiza była jak najpełniejsza – oprócz tego Link Detox pobiera dane z kilku popularnych narzędzi. W darmowym trialu nie wyświetli informacji o usuniętych linkach tylko dokona analizy tych, które nadal się wyświetlają. Skan może potrwać nawet kilka godzin, więc warto go uruchomić i zająć się czymś innym, aby wrócić do narzędzia później. Wynik analizy prezentuje się następująco:

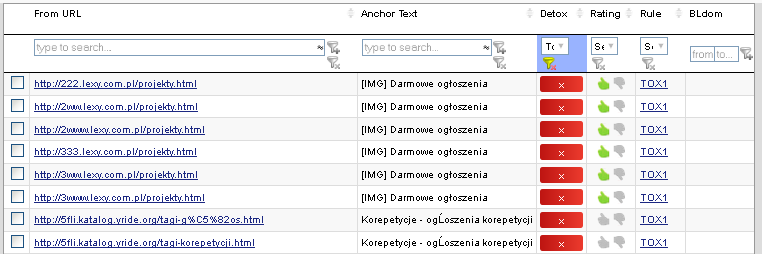

Po kliknięciu w wybrany rodzaj linków (np. Toxic – Toksyczne) wyświetla się ich pełna lista wraz z następującymi informacjami:

- adres strony z linkiem;

- anchor tekst;

- reguła, na podstawie której uznano link za toksyczny;

- kilka wskaźników określających wartość domeny linkującej;

- adres e-mail do webmastera;

które można rozszerzyć m.in. o:

- adres strony docelowej;

- status linka (nofollow, dofollow);

- lokalizacja linka (np. stopka, header, komentarz itp.).

To tylko część spośród wszystkich dostępnych informacji. To co powinno nas zainteresować w pierwszej kolejności, to reguły (kolumna „Rule”). Toksyczność linków określają tylko 2 reguły:

- TOX1 – brak indeksacji domeny w Google;

- TOX2 – szablon strony znajduje się na liście niebezpiecznych (wirusy itp.).

Niestety nie można się dowiedzieć, na jakiej podstawie i gdzie znajduje się lista podejrzanych szablonów, jednak w przypadku 1 z reguł należy zwrócić uwagę na to, czy przypadkiem robot nie trafił przypadkiem na automatycznie wygenerowaną subdomenę (np. asd.lexy.com.pl – przykład poniżej), która zwraca identyczną zawartość co prawidłowa domena, ale faktycznie nie będzie zaindeksowana. W pozostałych przypadkach zazwyczaj reguła działa poprawnie i pozwala znaleźć słabe zapleczówki, które są zbanowane i/albo przekierowują już na nowe domeny.

Warto również przyjrzeć się linkom oznaczonym jako podejrzane (Suspicious). Narzędzie zalicza do nich m.in.:

- linki na słabo podlinkowanych domenach;

- sieci linków – rozpoznane na podstawie dużej liczby backlinków z tej samej C klasy, z tych samych IPków, należące do tego samego właściciela, z tym samym kodem Google Analytics, Google Adsense i na podstawie wielu innych czynników;

- linki site-wide ze stopek;

- linki z wpisów w katalogach i z precli;

- linki ze starych domen, których nawet strony główne nie mają PR.

Pełna lista reguł dla linków podejrzanych znajduje się tutaj. Jak widać, nie powinno się polegać wyłącznie na automacie, jednak poszczególne reguły od razu podpowiadają, na co zwrócić uwagę. Nawet przy pozostałych linkach (reguła „Healthy”) warto je przejrzeć, bo z kolei wśród nich mogą znaleźć się linki niezbyt dobrej jakości. Przy okazji, narzędzie można wykorzystać do analizy backlinków konkurencji i znaleźć ciekawe źródła linków uznanych jako „zdrowe”.

Jeśli ktoś woli zaryzykować i polegać wyłącznie na tym narzędziu, może od razu wygenerować plik disavow. Można też zaznaczyć, aby w przypadku wykrycia wielu linków na tej samej domenie, narzędzie zamiast wypisać kolejno wszystkie linki, skorzystało z zapisu w postaci domain:domena.pl. Jednak w pierwszej kolejności powinno się usunąć jak najwięcej podejrzanych linków, a zgłaszać wystarczy te, których nie udało się zlikwidować.

No dobrze, wiemy już jak korzystać z narzędzia Link Detox, bez zbytniego zaangażowania czasowego. A co jeśli jednak chcemy wykonać analizę bardziej szczegółowo? Na podstawie dotychczasowych przypadków, szkodliwymi linkami okazują się być:

- linki profilowe – w szczególności, jeśli są masowo zakładane i wyświetlają się głównie na zagranicznych stronach, w tym na forach;

- linki z wpisów w katalogach stron – w szczególności te dodawane masowo, a zatem głównie przy korzystaniu z multikodów;

- linki z precli – również te dodawane hurtowo, zazwyczaj w postaci synonimizowanych tekstów;

- linki z komentarzy na blogach i forach – po raz kolejny, te dodawane masowo Scrapeboxem czy Xrumerem;

- SWLe – chociaż z tymi jest najłatwiej, bo wystarczy odpięcie strony, albo prośba do właściciela systemu o blokadę domeny i usunięcie prowadzących do niej linków;

- linki ze słabej jakości zaplecza – jeśli dodatkowo są zamieszczone w bardzo schematyczny sposób i mają przeoptymalizowane anchory. W takim przypadku jednak warto spróbować zmienić sposób ich wyświetlania, zamiast od razu usuwać.

Problemem jest połączenie masowości, słabej jakości stron i przeoptymalizowanych anchorów, a co za tym idzie – schematyczności działań. Dotychczas ręczne filtry widziałam głównie na serwisach, które miały ponad 500 domen linkujących, chociaż większość była bliżej 1000, a nawet kilku tysięcy.

Na zakończenie odsyłam do działu „Filtry i bany”, w którym opisałam m.in. częste błędy przy odfiltrowywaniu stron oraz co robić, jeśli konkurencja zacznie nas linkować.

Zachęcam do podzielenia się informacjami na temat linków, które w Waszych przypadkach zawiniły. Czy Wasze spostrzeżenia zgadzają się z moją listą „potencjalnie szkodliwych linków”?

Anglojęzycznym znajomym możecie podrzucić artykuł „Link Detox – how to recognize toxic links„.