Ostatnimi czasy nagromadziło się sporo nowych mitów SEO, inne z kolei są powtarzane już od lat. Postanowiłam odnieść się do części z nich, porównując krążące w branży teorie z potwierdzonymi informacjami. Dotychczas podobne wpisy publikowałam w postaci sprawdzenia 3 mitów i myślę, że warto tę formę zachować. Zaczynamy od tego, czy faktycznie w niedługim czasie nastąpi rewolucja w SERPach, poruszę również temat BR i CTR z wyników wyszukiwania. Będę kontynuować numerację, którą rozpoczęłam w tym wpisie.

Ostatnimi czasy nagromadziło się sporo nowych mitów SEO, inne z kolei są powtarzane już od lat. Postanowiłam odnieść się do części z nich, porównując krążące w branży teorie z potwierdzonymi informacjami. Dotychczas podobne wpisy publikowałam w postaci sprawdzenia 3 mitów i myślę, że warto tę formę zachować. Zaczynamy od tego, czy faktycznie w niedługim czasie nastąpi rewolucja w SERPach, poruszę również temat BR i CTR z wyników wyszukiwania. Będę kontynuować numerację, którą rozpoczęłam w tym wpisie.

Lista mitów:

- Mit #4 – Google planuje zrezygnować z uwzględniania backlinków w rankingu, wprowadzając algorytm Knowledge-Based Trust (KBT)

- Mit #5 – Google będzie karać za brak wersji responsywnych stron

- Mit #6 – CTR z SERPów i BR mają wpływ na ranking w Google

Mit #4 – Google planuje zrezygnować z uwzględniania backlinków w rankingu, wprowadzając algorytm Knowledge-Based Trust (KBT)

News o czekającej nas zmianie algorytmu Google obiegł świat po tym, jak udostępniony został dokument Knowledge-Based Trust: Estimating the Trustworthiness of Web Sources.

Dokument ten to nic innego, jak opis badań zespołu Google i jego propozycja bazowania na wskaźniku zaufania do strony, który ma wynikać z tego, czy publikuje ona fakty, a więc informacje sprawdzone i potwierdzone przez inne źródła. Potwierdza to fragment wstępu do dokumentu:

We propose a new approach that relies on endogenous signals, namely, the correctness of factual information provided by the source.

Zacznijmy od tego, że ten dokument to jedynie szczegółowo opisana koncepcja. Nie było jednak nigdzie wzmianki o tym, że Google ten pomysł zaakceptowało i postanowiło go wdrożyć. Kolejna sprawa, to że nawet we wspomnianym opracowaniu nie pisze się o całkowitej zmianie aktualnego algorytmu. Wręcz przeciwnie, poniższy fragment mówi wprost, że taka forma oceny mogłaby współistnieć wraz z innymi czynnikami rankingowymi, w tym z PR.

We note that source trustworthiness provides an additional signal for evaluating the quality of a website. We discuss new research opportunities for improving it and using it in conjunction with existing signals such as PageRank (…)

Skąd zatem to całe poruszenie na temat planowanego wprowadzenia nowego algorytmu i rezygnacji z backlinków, skoro oryginał dokumentu tego nie potwierdza? Wygląda na to, że to jedynie kwestia nieprawidłowej interpretacji i szybkiego rozprzestrzeniania się tej informacji. Jeśli jednak ktoś z Was widział wypowiedź jakiegokolwiek Guglarza, który potwierdził planowanie wdrożenia opisanej tu zmiany, będę wdzięczna za sprostowanie, bo jak na razie mit traktuję jako:

Edycja 11 marca 2015 r.

Mamy już potwierdzenie bezpośrednio od Johna Muellera, że dokument, z którym mieliśmy okazję się ostatnio zapoznać, to jedynie dokument czysto badawczy, a nie opisujący aktualnie działający algorytm. Link do wypowiedzi: www.youtube.com/watch?v=ujq-OTI5ET8#t=2961

Mit #5 – Google będzie karać za brak wersji responsywnych stron

26 lutego 2015 r. na blogu Google pojawiła się następująca informacja:

Starting April 21, we will be expanding our use of mobile-friendliness as a ranking signal. This change will affect mobile searches in all languages worldwide and will have a significant impact in our search results. Consequently, users will find it easier to get relevant, high quality search results that are optimized for their devices.

Wynika z niej, że 21 kwietnia 2015 r. wprowadzony zostanie nowy czynnik rankingowy, jakim jest dostosowanie strony pod kątem urządzeń mobilnych. Zmiana dotyczyć będzie użytkowników urządzeń mobilnych na całym świecie. Ani słowem nie wspomniano, że mobilność strony wpłynie również na ranking w wynikach wyszukiwania dostępnych z komputerów, bo czemu miałaby mieć na nie jakikolwiek wpływ? Dla Google istotne będzie to, czy wyświetlona w wynikach strona jest przystosowana do urządzenia, za pośrednictwem którego na nią trafiono.

News oczywiście brzmiał lepiej, jeśli wzbogaciło się go o informacje wynikające z błędnej interpretacji. Zaczęły więc padać stwierdzenia na temat tego, że strony nieprzystosowane do urządzeń mobilnych będą wręcz karane, zabrakło również wzmianki o tym, że zmiana nie dotyczy standardowych wyników wyszukiwania. Podkreślam zatem, że źródło tej informacji podkreśla, iż jest to zmiana dotycząca użytkowników mobilnych, a druga sprawa, to nie ma tam mowy o żadnych karach, a jedynie o premiowaniu wyników mobile-friendly.

Na ten temat wypowiedział się sam John Mueller podczas jednego z ostatnich hangoutów:

W 25. sekundzie mówi o tym, że zmiana dotyczy tylko smartfonów. Rozwinął to w dalszej części spotkania dodając, że nic mu nie wiadomo o tym, aby miała ona dotyczyć także komputerów.

Na podstawie powyższych informacji, mit uznaję za:

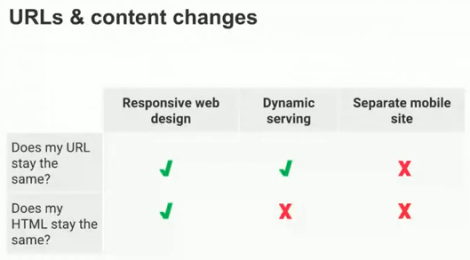

Do tematu tego odniosłam się bardziej szczegółowo we wpisie Co faktycznie oznacza wprowadzenie mobilności jako czynnika rankingowego?. Warto również dodać, że nie ma większego znaczenia, czy zdecydujemy się na wersję RWD czy inny sposób zapewnienia strony mobile-friendly. Dostępne są 3 zaprezentowane poniżej sposoby, ale po szczegóły na ich temat odsyłam do pełnego filmiku, ponieważ to nie temat tego wpisu.

Mit #6 – CTR z SERPów i BR mają wpływ na ranking w Google

Ostatnio głośno jest o czynnikach behawioralnych i ich prawdopodobnym wpływie na ranking w Google. Chodzi głównie o CTR z SERPów oraz BR, o których wspomniałam w tym wpisie. W tym miejscu warto również zapoznać się z 2 wpisami Konstantina: Yandex ukarał setki stron za manipulowanie czynnikami behawioralnymi i Czy emulacja czynników behawioralnych daje efekty? Fala kar za zastosowanie SeoPult’a, z których można się dowiedzieć, jak to wygląda w Yandexie.

Wracając do Google, moim zdaniem jest wysoce prawdopodobne, że Google wykorzystuje w rankingu te dane, do których najzwyczajniej w świecie ma dostęp. A takimi danymi są m.in. CTR z SERPów (badany na pewno przez parametr &cd=) oraz BR (te dane z pewnością łatwo jest wyciągnąć z logów Google). Nie zdziwiłabym się zatem, gdyby Google obniżało pozycje stron ze słabym CTR oraz wysokim BR (w sytuacji, kiedy użytkownik przechodzi z wyników wyszukiwania na znalezioną stroną i szybko powraca do wyników wyszukiwania).

Nie wykonywałam jeszcze testów w tym zakresie, dlatego tym razem powołam się na materiał opublikowany jakiś czas temu przez Bartka Góralewicza. Opisał on przypadki 2 stron jego klientów, które miały problem z pozycjami. Po wykluczeniu pozostałych elementów, które mogły być przyczyną problemów, wszystko wskazywało na to, że jedna z nich ucierpiała w wyniku manipulowania CTR w SERPach (wyszukiwanie fraz brandowych i odwiedzanie stron konkurencji, ale nie strony analizowanej przez Bartka). Po wykonaniu testów skupiających się na tym elemencie okazało się, że testowa strona (w tym przypadku jego blog) spadła mocno w rankingu po tym, kiedy przygotowany specjalnie bot wyszukiwał testowej frazy i klikał losowo w różne wyniki, za wyjątkiem wpisu na jego blogu.

Ponieważ testów nie przeprowadzałam sama, a tych potwierdzających możliwość manipulowania pozycjami przez CTR czy BR jest niewiele, postanowiłam ocenić ten mit jako:

Tym samym uważam, że warto przyjrzeć się temu tematowi bliżej i wykonać serie testów na dużą skalę tak, aby nie zaburzały ich inne czynniki rankingowe. Co prawda pracownicy Google zaprzeczają, jakoby wspomniane czynniki miały wpływ na ranking, jednak dobrze wiemy, że nie po raz pierwszy dowiadujemy się o czymś po fakcie. W końcu przekazywanie nam tego typu informacji nie leży w interesie wyszukiwarki, stąd też konieczność samodzielnego sprawdzenia, czy coś w tym jest.